知らない「私」がトランプ支持者に

ドイツに住むモデルのデビー・ネデロフさん。

インスタグラムに投稿した自分の画像が勝手に使われ、何者かによってトランプ氏を支持する「ウィスコンシン州在住の32歳のルナ」という、架空の人物になりすまされる被害に遭った。

ネデロフさんによると、旧ツイッターの「X」につくられた偽アカウントは、少なくともことし7月から8月にかけて、トランプ氏への支持を呼びかける投稿を繰り返していた。

「私たちの大統領、トランプ氏に投票するのが待ちきれません」

「トランプ氏に投票するならあなたのアカウントをフォローします」

使われた画像は生成AIなどによって合成されたものではなく、ネデロフさん自身の写真だ。

当時の記録から「ルナ」という架空の人物のアカウントには約3万人のフォロワーがいて、投稿の中には30万人以上に届いたとみられるものもあることがわかった。

ネデロフさん

「非常にショックを受けました。政治には関心がありますが、自分の意見をネット上で共有したことは一度もありません。多くの人が偽アカウントの投稿を見て、それを私だと思い込むのは非常に危険なことだと思います」

この偽アカウントについて、ネデロフさんはSNSの運営会社に通報したが、すぐには対応はされず、アメリカメディアなどの報道でなりすましの問題が明るみに出た8月下旬以降、Xの運営会社によって最終的に停止されたとみられる。

一連の経験を、ネデロフさんは次のように振り返っている。

ネデロフさん

「なぜ私の写真が使われたのかわかりません。勝手に使った人物は『若いヨーロッパの女性だと投稿した写真を多くの人が見るし、アメリカからは遠いので、本人に数か月、もしかすると気付かれないかもしれない』と考えたのだと思います。以前は、ソーシャルメディアは自分の趣味や物語を共有できる大きなチャンスになると思っていましたが、いまは非常に危険なものだと思っています」

サタデーウオッチ9(10月5日放送予定)

それによると、このサイトは9月上旬に公開されたとみられ、実在しないサンフランシスコの地元テレビ局のニュースサイトを装っていた。

サイトにはフロントガラスにひびが入った車の写真や「当時13歳の少女が被害者となった2011年のひき逃げ事故」などとする偽の記事とともに、インタビューとナレーションで構成されたニュース番組の一部のような、およそ5分間の動画が掲載されていた。

動画では「被害者」だと主張する女性が次のように語っていた。

「自分をひき逃げした人物がカマラ・ハリス氏だとあとになって知らされた。母を怖がらせたくなかったが、数か月前に母が亡くなり、このことを公表しようと思った」

偽のインタビュー動画はSNSなどを通じて拡散され、情報大手マイクロソフトの分析によると、この動画は合わせて数百万回視聴されたという。

ほかにも、このサイトの「インターネット上の住所」に相当する「ドメイン」が、サイトが公開される直前のことし8月下旬に登録された記録が残されていることや、掲載されていたひびの入った車の写真が2018年にアメリカ・グアムで起きた事故のものとみられるなど、正規のニュースサイトとするには不自然な点が複数、見つかった。

生成AI使用で改ざんか

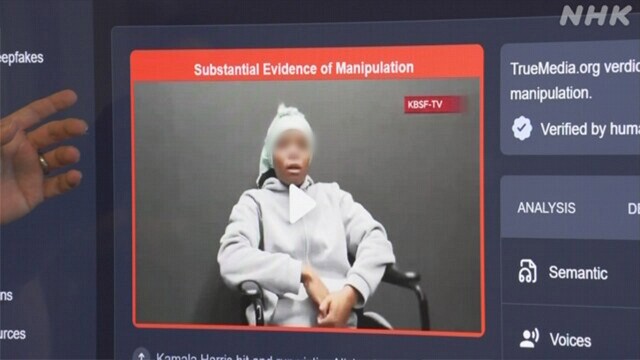

この偽のインタビュー動画はどうやってつくられたのか。

私たちは、生成AIを使った偽情報に詳しいワシントン大学のオレン・エツィオーニ名誉教授のいるシアトルを訪ねた。

エツィオーニ名誉教授らの研究チームは、ネット上に公開されたコンテンツが生成AIでつくられた偽情報かどうかを判定できるツールを開発していた。

そのツールは、動画や画像、それに音声を対象に、生成AIで作られた痕跡があるかどうかや言葉の意味の流れが自然かどうかなどといった観点で分析し、生成AIでつくられたり改変されたりした可能性がどの程度あるのか、1分ほどで判定してくれる。

エツィオーニ名誉教授に「被害者のインタビュー」として拡散された動画を、開発したツールを使って分析してもらったところ、話している女性の表情や声など複数の点で生成AIが関わった痕跡が見つかり、この動画は「AIで改ざんされた証拠が十分にある」と判定された。

エツィオーニ名誉教授

「動画を見ると女性の口の動きが完全には自然ではないことがわかる。いまはよく見れば偽物だとわかるが、声と口の動きを一致させる技術は近い将来、さらに向上し、こうした分析ツールを使わなければ見分けるのは難しくなるだろう」

ネット上にあふれる偽情報に対抗しようと、エツィオーニ名誉教授は9月、このツールを誰でも使えるよう無料で公開した。

エツィオーニ名誉教授

「このツールは、当初、分析結果を広く共有できるメディア関係者や、ファクトチェックの担当者が使っていたが、選挙が近づくにつれ、各地域の選挙事務所などで選挙に直接、関わり、偽情報や干渉に対処できるよう備えている人や、一般の人が使うことにも注目している。このツールを使う人はほんの一部にすぎないが、ほかの人と情報を共有してくれることを望んでいる」

ロシアの影はほかにも

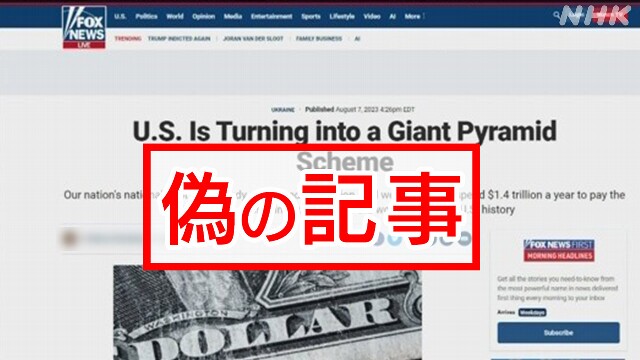

ロシア側が関わったとされる偽情報は、ほかにも確認されている。

このうちロシア側が作成に関与したとして、9月、アメリカの司法当局が摘発したケースでは、有力紙「ワシントン・ポスト」や、アメリカの「FOXニュース」とそっくりのサイトが作られていた。

ロゴやレイアウトは本物と見分けがつかず、サイトのURLも、一部をわずかに変えただけで、巧妙に本物と信じ込ませることをねらっているようだった。

このサイトには、実在する記者の執筆を装った架空の記事が掲載されていた。記事にはバイデン政権の政策を批判する内容などが含まれていた。

司法当局は、アメリカ大統領選挙に対し、何らかの影響を与えようとしていたとみている。

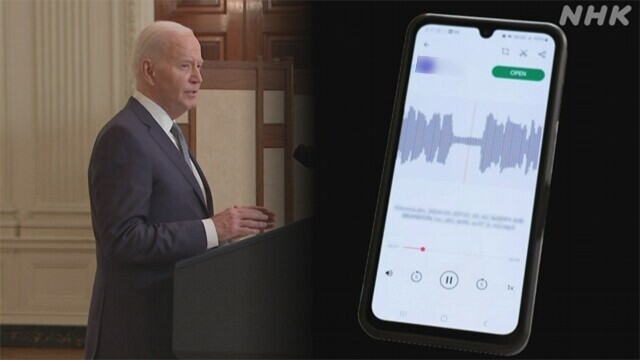

声のフェイクも

今回のアメリカ大統領選挙をめぐっては、生成AIで作られたさまざまな偽情報がSNSなどを使って拡散され、大きな問題となってきた。

ことし1月には、大統領選挙に向けた予備選挙の直前に、バイデン大統領に似せてAIで作成されたとみられる音声を使って、予備選挙に行かないよう呼びかける電話がニューハンプシャー州の多くの住民にかかってくる事件が発生した。

アメリカの司法当局は50代の政治コンサルタントをこの事件に関わり、選挙を妨害したなどとして起訴した。

この偽音声は、この政治コンサルタントから依頼を受けたという40代のマジシャンの男性が作成していたという。

この男性はNHKの取材に対し「登録すれば誰でも使えるオンラインの音声生成サービスを利用し、10分程度で作った」と話した。

もしもう一度、依頼を受けたらどうするかと尋ねると、男性は「やる」と即答したあと、力を込めてこう答えた。

「私がやらなくても誰かがやるし、誰でもできる」

“チープフェイク”も

さらには、生成AIを使わず、一般的な映像や音声の編集・加工ツールを使って改変したとみられる偽情報がSNSで拡散されるケースも起きている。

こうした偽情報は、生成AIを使ってつくりだされる「ディープフェイク」に対して、「安い偽情報」を意味する「チープフェイク」と呼ばれることもある。

例えば、9月、SNSで拡散されたホワイトハウスでの記者会見の動画は、記者から質問を受けた報道官が何も答えず、一方的に会見を切り上げたような印象を与えている。

しかし、当時の記者会見の記録からは、実際には報道官が質問に答えていることがわかり、回答している部分の映像を意図的に削除してつなぎ合わせた動画とみられる。

こうした「チープフェイク」と「ディープフェイク」が、与える影響に違いがあるのか。

エツィオーニ名誉教授は次のようにとらえている。

エツィオーニ名誉教授

「多くの人が疑問を持つような『チープフェイク』でも驚くほどたくさんの人が見ている。非常に高度な技術を使った『ディープフェイク』が必ずしも勝るわけではなく、『チープフェイク』が説得力を持つこともある。結局、必要なのはメディア・リテラシーで、見たものをそのまま信用することは、もはやできないことを理解する必要がある」

予測できないが備えは必要

アメリカ大統領選挙の投票日が近づくにつれ、さまざまな偽情報がさらに増えると複数の専門家が予想する。

投票日を迎えるタイミングに、いったい何が起きるのか。偽情報の専門家は、次のように警鐘を鳴らした。

エツィオーニ名誉教授

「今回の選挙は接戦で、ほんの少しの変化が勝敗を左右する。一方、巧妙な偽情報をどれだけ見ようが、トランプ氏の支持者はトランプ氏支持で、ハリス氏の支持者はハリス氏支持だ。最も影響を受けやすいのは、まだ決めていない人、そもそも投票に行くか分からない人だ。選挙を混乱させるためにさまざまな手段が使われる。偽情報はリスクとなるが何が起きるか予想はできない。いわば地震のようなものだ。私たちは、それを阻止する準備ができていなければならない」

(アメリカ総局・田辺幹夫)

“移民がペットを食べている” 根拠ない情報はどう広がったか

鄭重声明:本文の著作権は原作者に帰属します。記事の転載は情報の伝達のみを目的としており、投資の助言を構成するものではありません。もし侵害行為があれば、すぐにご連絡ください。修正または削除いたします。ありがとうございます。